香港中大-商湯科技聯合實驗室AAAI錄用論文詳解:自監督語義分割的混合與匹配調節

這篇文章介紹了香港中大-商湯科技聯合實驗室的新論文「Mix-and-Match Tuning for Self-supervised Semantic Segmentation」,該論文被 AAAI 2018 錄用為 Spotlight。

作者:Xiaohang Zhan、Ziwei Liu、Ping Luo、Xiaoou Tang、Chen Change Loy

用于語義分割的卷積神經網絡通常需要大量的標注數據來進行預訓練,例如 ImageNet 和 MS-COCO。自監督學習最近被提出來,主要用來減少標注工作量,它的預訓練過程中無需任何人工標注。此項研究已經在圖像分割領域中得到了應用(Zhang, Isola, and Efros 2016a; Larsson, Maire, and Shakhnarovich 2016; 2017)。其關鍵在于,在此過程中引入了一個無監督的「預訓練任務」,這個任務可以在無標注數據上執行,用來學習圖像的描述。然而,很多預訓練任務缺乏能夠對目標任務進行有效區分的監督信號,導致最終的結果比有監督的初始化要低很多。在本文的研究中,我們通過引入「混合與匹配」的機制來解決這個局限性。這個機制可以兼容很多自監督與訓練方法,相比于原來的方案無需更多的標注數據。利用了「混合與匹配」機制的自監督初始化模型,其最終結果可以匹敵甚至超越全監督的初始化模型。

自監督學習通常分為兩個步驟:無監督的預訓練和對目標任務的微調。預訓練步驟不只需要數據本身,而無需數據的標注結果。它需要設計一個預訓練任務,利用從數據本身到的的監督信號來訓練。例如,圖像上色任務(Larsson, Maire, and Shakhnarovich 2017),利用了圖像可分解成亮度和色彩這樣的特點,通過輸入圖像亮度,來預測圖像的顏色。在此過程中學習到帶有某種程度語義的圖像描述子,并將之通過微調應用在最終的語義分割任務上。自監督學習展現出其強大的學習能力,即使在沒有標注的數據上,也能獲得不錯的初始化效果,大大超越了隨機初始化的模型。

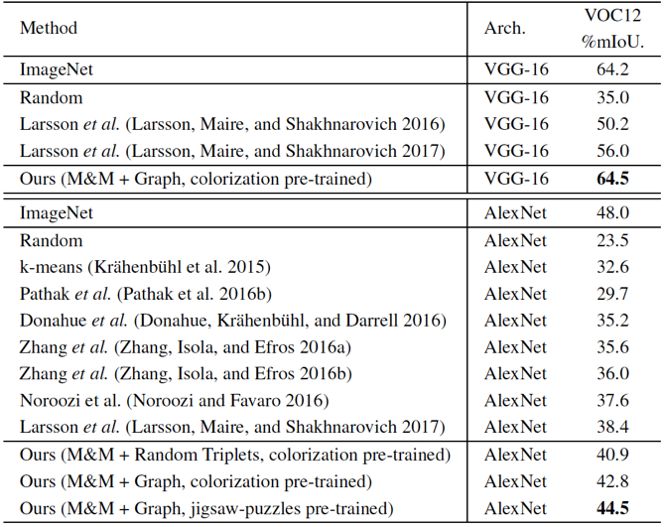

盡管自監督學習很有前景,但目前其表現結果還遠不如有監督的初始化。例如,使用 VGG-16 網絡,用圖像上色來進行預訓練,在 PASCAL VOC2012 上能得到 56.0% mIoU 的結果,大大超過隨機初始化的 35.0% mIoU 的結果。但用 ImageNet 分類任務來初始化,則可以達到 64.2%。這說明自監督預訓練和有監督預訓練之間還有較大的差距。

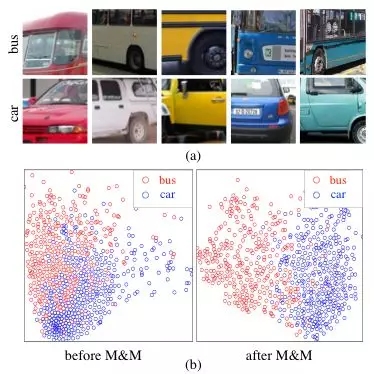

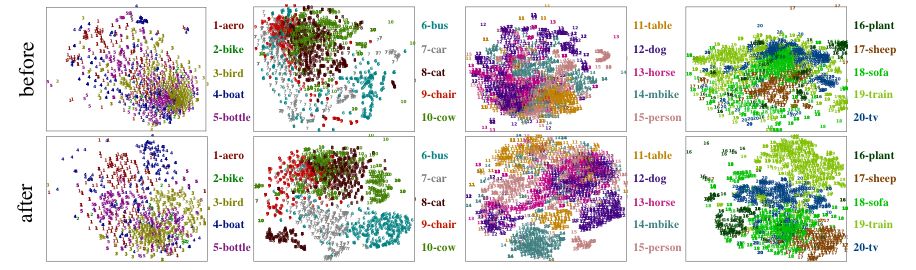

圖一:(a)展示了來自「汽車」和「巴士」兩個類別的圖像塊,它們具有非常相近的色彩分布。(b)展示了這兩個類別的深層特征分布,執行過「混合與匹配」的特征對于這兩個類別有更好的區分性。

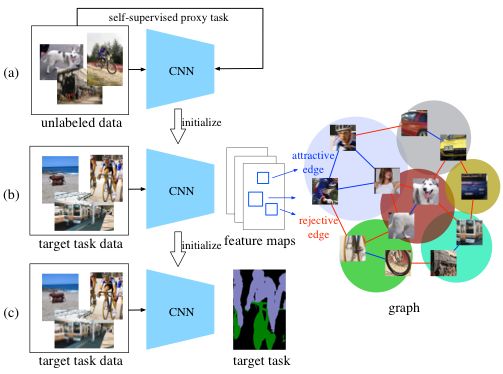

圖二:我們提出的方法的整體流程圖。我們的方法在自監督預訓練任務與最終目標任務之間插入了「混合與匹配」過程。

我們認為這個差距的主要原因在于,自監督預訓練任務和最終的目標任務在語義層次上有較大的區別。例如對于圖像上色來說,這個任務中網絡能學到對顏色分布比較敏感的圖像描述子,這樣的描述子對圖像上色很有幫助,但對更高的語義層次,其作用會弱很多。例如,在圖一(a)中,汽車和巴士的顏色分布非常接近,因此基于圖像上色得到的圖像描述子,對于汽車和巴士會有大范圍的重合,難以區分,見圖一(b)。

要提升自監督圖像分割的表現,需要讓圖像描述子對目標任務有更好的區分能力。然而這個目標并不容易,因為圖像分割的數據集通常很小,其標注數量很少,一般來說只有幾千張圖片。現有的方法一般用「Softmax」損失函數來利用這些標注,對于初始化得很好的有監督初始化網絡,它是足夠有效的,但對于初始化較差的自監督初始化網絡,「Softmax」是不夠的。我們認為,利用以像素為單位的圖像分割的標注,「Softmax」并不是唯一的方式。

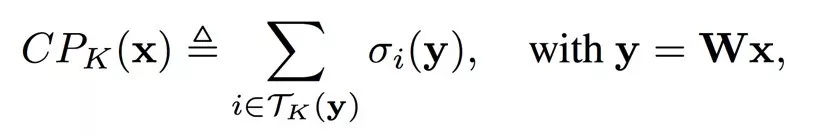

在這項研究中,我們提出了一個新的策略,叫「混合與匹配」(Mix-and-Match),來更好地利用有限的標注信息,從而提升自監督初始化網絡的性能。見圖二,「混合與匹配」緊接自監督預訓練任務之后,作為一個中間過程用來彌補預訓練任務和目標任務之間的差距。值得注意的是,此過程只使用了目標任務的數據和標注,并不需要額外的數據或標注。

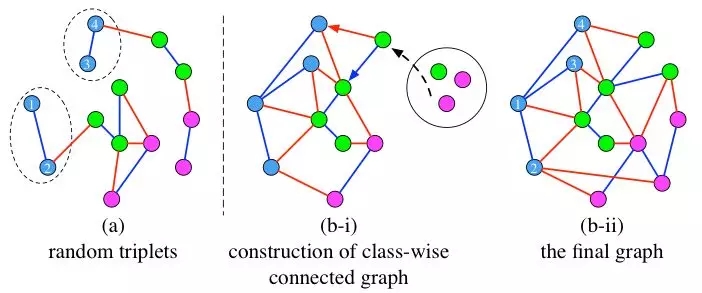

此過程分為「混合」與「匹配」兩個步驟。在「混合」步驟中,我們從目標任務圖像中隨機抽樣了大量的局部圖像塊并混合在一起。這些圖像塊跨越了多張圖像,因而能夠減弱圖像內部的相關性,從而無偏地反映目標圖像的分布。由這些圖像塊組成的大量的三元組也能夠為優化提供穩定的梯度。在「匹配」過程中,我們構建了一個無向圖,它的節點即圖像塊的深層特征。它有兩種類型的邊,如果兩個圖像塊屬于同一類,那么我們定義為「相吸邊」,反之,則定義為「相斥邊」。我們通過迭代的方式構建的圖可以確保同類的節點組成一個連通子圖,見圖三。在此方式構建的圖中,我們可以獲得更加魯棒的三元組,能夠讓網絡學會將同類的圖像塊映射到同一個點上,或者說優化的過程中使得它們的描述子在歐幾里得空間中構成單個中心,而非多個中心,并且使得不同類之間具有較大的距離。我們抽樣三元組的方式和以往的工作具有非常大的不同。

圖三:此圖展示了不同的構建三元組的方式。節點的顏色代表其類別。藍色和紅色的邊分別代表「相吸邊」和「相斥邊」。(a)是隨機選擇的三元組(Schroff, Kalenichenko, and Philbin 2015),其中來自相同類的節點不能構成一個連通圖。(b-i)和(b-ii)是我們通過構建無向圖來構建三元組的方法。我們構建的無向圖中,每一類都分別構成一個連通子圖。

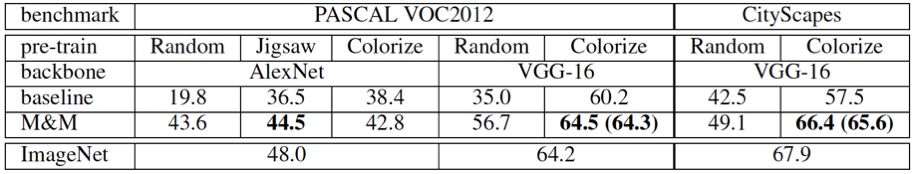

我們的工作的貢獻主要有:1. 我們提出了「混合與匹配」的調節機制,首次讓自監督預訓練的模型超過了有監督預訓練的模型。具體來說,在 PASCAL VOC2012 數據集上,在 VGG-16 網絡上,使用圖像上色作為預訓練任務,我們的方法獲得了 64.5% mIoU 的性能,超過了 ImageNet 分類作為預訓練任務的模型,64.2%。在 CityScapes 數據集上,我們得到了 66.4% 的性能,匹敵 ImageNet 預訓練的結果,67.9%。此提升極具顯著性,考慮到我們的方法是基于無監督預訓練的。2. 除了利用圖像上色作為預訓練任務,我們還利用基于圖像內容的自監督方法——Jigsaw Puzzles,獲得了較大的提升。3. 使用隨機初始化,在不同網絡結構和不同數據集上,我們的方法也獲得了顯著的提升。這使得隨機初始化訓練語義分割成為可能。4. 我們提出的一種新的基于類內連通圖的三元組抽樣方案,相比于傳統的三元組抽樣方案更加魯棒。

表一:在此數據集是公認的語義分割數據集,PASCAL VOC2012 數據集上的結果對比。我們的方法同時在 VGG-16 和 AlexNet 上大幅度超過了目前最好的基于自監督初始化的方法,并且在 VGG-16 上超過了 ImageNet 初始化的方法。

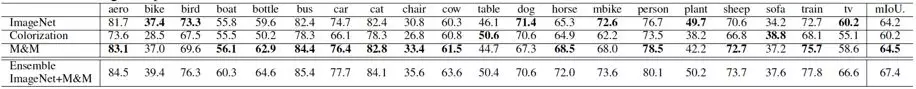

表二:PASCAL VOC2012 上單類語義分割結果。

圖四:此圖展示了使用了我們的方法之后,圖像特征分布的變化。

表三:此表格展示了不同數據集下,用不同網絡結構,和不同預訓練任務(包括隨機初始化),我們的方法獲得的提升效果。

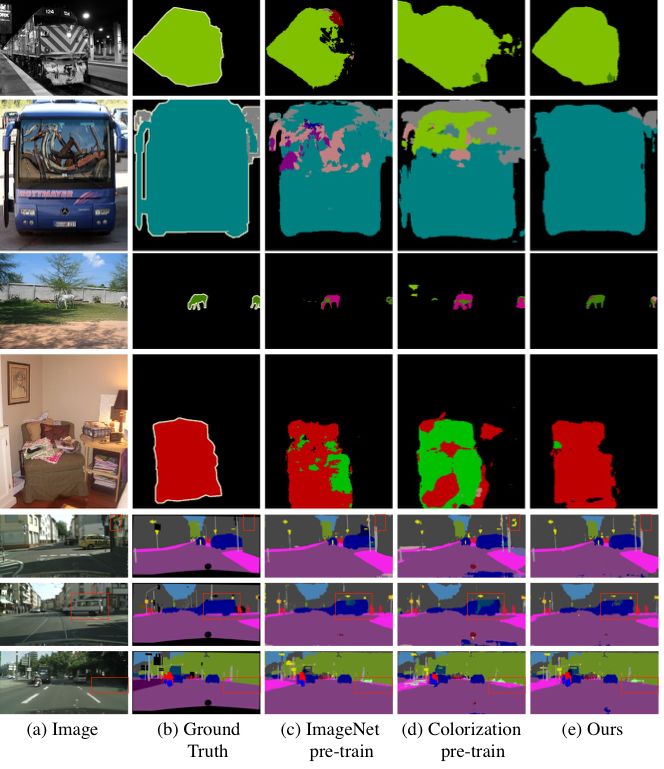

圖五:結果可視化。

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化